Мощь процессоров в эру апскейлеров становится еще важнее

Уже ни для кого не секрет, что сейчас практически в каждой новой игре есть минимум один апскейлер изображения, который помогает обойти ограничения производительности видеокарт в условиях невероятно высоких требований к ним. Также все понимают, что включая DLSS/XeSS/FSR/TSR или любой иной апскейлер нагрузка на видеокарту снижается в первую очередь благодаря тому, что игра начинается рендериться в более низком разрешении, а вместе со снижением нагрузки на ГПУ высвобождаются ресурсы для рендера большего количества кадров. Больше FPS = лучше, спору нет, но тут возникает еще одно бутылочное горлышко — медленный процессор. Tom's Hardware провели тесты трех процессоров из разных ценовых сегментов и выяснили в какой степени ЦПУ влияет на производительность ГПУ при использовании DLSS.

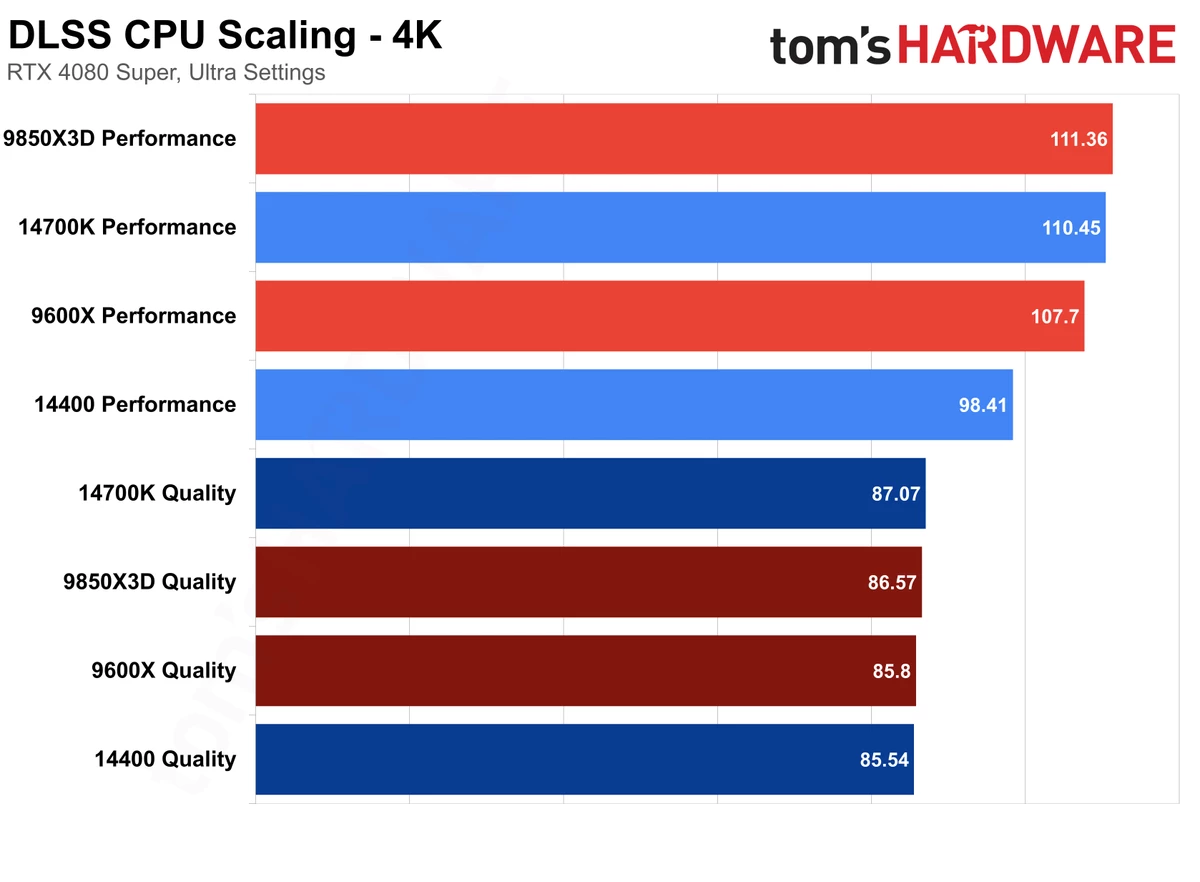

В тестах участвовали AMD Ryzen 7 9850X3D и R5 9600X, а также Intel Core i7-14700K и i5-14400. В качестве видеокарты использовалась далеко не топовая RTX 4080 Super, а выводы совсем не утешительные для фанатов "синих" процесоров. Да, в 4К все упирается в бедную видеокарту с парой старших "камней" и почти упирается с 9600X даже при DLSS в режиме производительность. С более мощной видеокартой (RTX 4090/RTX 5090), конечно, разница была бы куда более заметной в том числе и при DLSS Q в 4К.

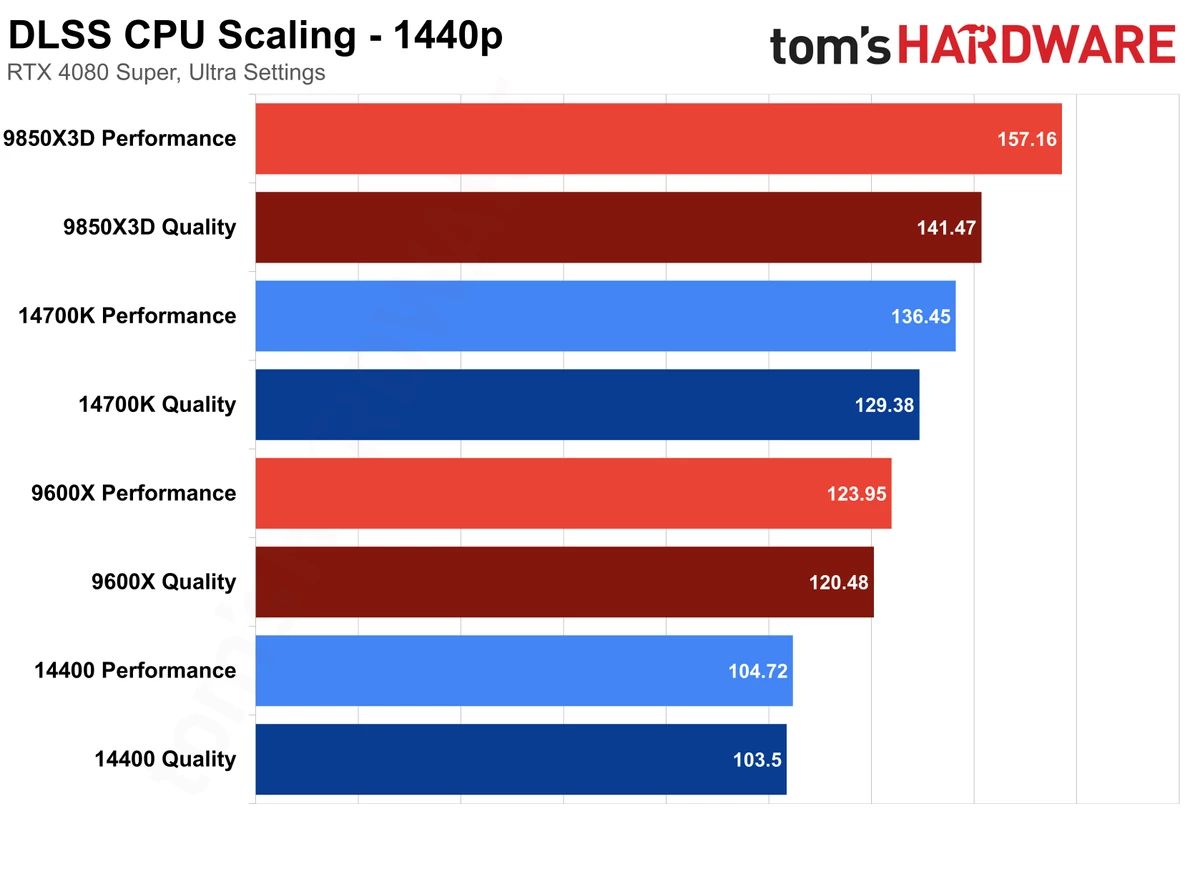

А вот в 1440p, целевом разрешении для видеокарты уровня RTX 4080/5080, видеокарта будет недогружена вообще на всех "камнях" кроме 9850X3D. Причем с "рязанью" даже под DLSS Quality будет больше FPS, чем с любым другим процессором с DLSS Performance.

Тестирование проводилось на примере следующего списка игр: Spider-Man 2, Cyberpunk 2077, Microsoft Flight Simulator 2024, Doom: The Dark Ages и The Last of Us Part 1. Все проекты требовательны к процессорам, потому тестировать на их примере было адекватной идеей, а вот к выбору видеокарты возникают вопросы. Впрочем, как видно из графиков, даже RTX 4080 Super смогла указать бедным Intel Core и бюджетному 6-ядернику от AMD на их места.